De ce algoritmii sunt uneori periculoși și de ce inteligența artificială nu este chiar atât de ”smart” în prezent

Algoritmii sunt prezenți în toate aplicațiile online și iau decizii pentru noi, de multe ori simplificându-ne viețile, fiindcă ne arată lucrurile de interes și elimină ”balastul”. Însă algoritmii sunt, în multe cazuri, folosiți greșit și dacă avem încredere oarbă în ei, putem ajunge la un fals sentiment de securitate, explică Raffael Marty, vicepreședinte pentru securitate la compania Forcepoint. În articol puteți citi de ce algoritmii sunt periculoși, de ce încă avem nevoie de experți umani și de ce termenul de inteligență artificială este adesea folosit în mod exagerat.

Nu au empatie, nu sunt perfecți, dar sunt extrem de utili

Numele de algortim vine de la matematicianul arab de secol IX Al-Khwarizmi (Horezmi), iar algoritmii sunt practic liste de instrucțiuni destinate realizării unei operațiuni. Sunt un fel de ”rețete”, o serie de pași logici care te duc din punctul A în punctul B.

Algoritmii nu au empatie, nu sunt perfecți, fac greșeli, un exemplu fiind o discuție cu asistenții vocali care, deși sunt tot mai buni de la an la an, dau deseori răspunsuri neinspirate.

Nu ar trebui să așteptăm de la algoritmi să ia în numele nostru decizii cruciale pentru viața noastră și nu trebuie să ne bazăm 100% pe ei.

De ce? Fiindcă pornesc cu datele furnizate de oameni, algoritmii oglindesc prejudecățile noastre și reprezintă practic o ”fotografie” a realității înconjurătoare. Dacă, spre exemplu, dai o căutare în engleză cu ”profesor de matematică” pe Google Images, în doar o poză din 20 va apărea o femeie.

Companiile se bazează uneori orbește pe algoritmi

Vorbim tot mai mult de algoritmi, fiindcă îi întâlnim peste tot, celebre fiind exemplele Facebook, Google sau aplicațiile de traducere instantanee, fiindcă algoritmii și modul în care sunt configurați decid ce conținut ne este afișat.

Dar algoritmii sunt folosiți și de companiile de securitate informatică pentru a simplifica munca angajaților și pentru a duce la o detecție mai eficace a amenințărilor. Însă algoritmii trebuie folosiți cu grijă, fiindcă altfel rezultatele pot fi neprevăzute.

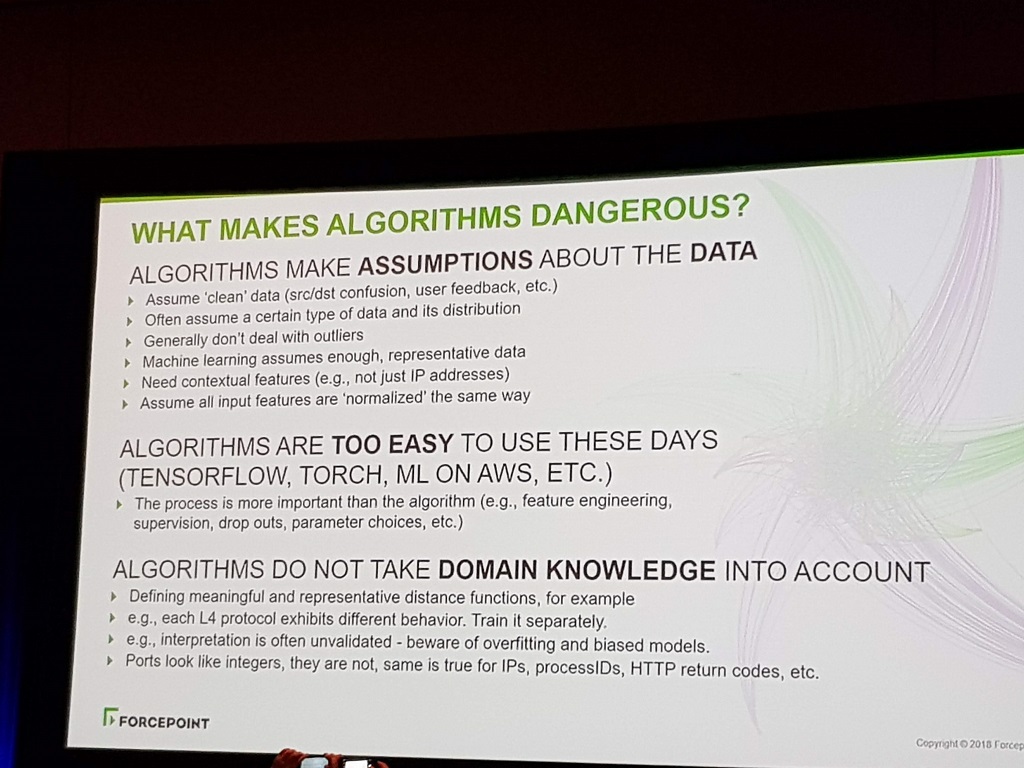

De ce pot fi algoritmii periculoși, slide din prezentarea lui Marty la Black Hat Las Vegas (foto – HotNews)

Toate companiile de securitate informatică vorbesc despre tehnici de machine learning și AI (aritificial inteligence). Însă sunt de multe ori vorbe goale, spune Raffael Marty care are 20 de ani de experiență în domeniu și a vorbit în detaliu despre subiect la conferința Black Hat Las Vegas.

Companiile, spune el, se bazează ”orbește” pe algoritmi și au încredere că aceștia vor face ce trebuie. În plus, algoritmii de ”deep learning” sunt folosiți pentru a detecta diverse anomalii, dar în multe cazuri companiile folosesc algoritmi pe care nu îi înțeleg și, în consecință, ajung să dea rezultate eronate.

Marty spune că tehnicile de ”machine learning” au limitări, ”deep learning-ul” nu trebuie folosit într-o serie de cazuri și adesea este cel mai bine să investim în sisteme care ”absorb” cunoștințele de la experți.

În plus, este folosit în exces conceptul de inteligență artificială. Nu avem încă inteligență artificială generală, adică un sistem inteligent care învață și apoi vine cu cunoștințe noi. Avem algoritmi ”smart”, dar dacă avem de-a face cu un sistem care doar clasifică, dar nu vine cu cunoștiințe noi, nu avem inteligență artificială, precizează Marty.

Ce face inteligența artificială azi? Câteva exemple sunt cunoscute: victoriile computerului la jocul de GO, contribuția programelor la descoperirea de noi medicamente sau îmbunătățirea continuă a asistenților vocali stil Siri, Google Assistent sau Alexa.

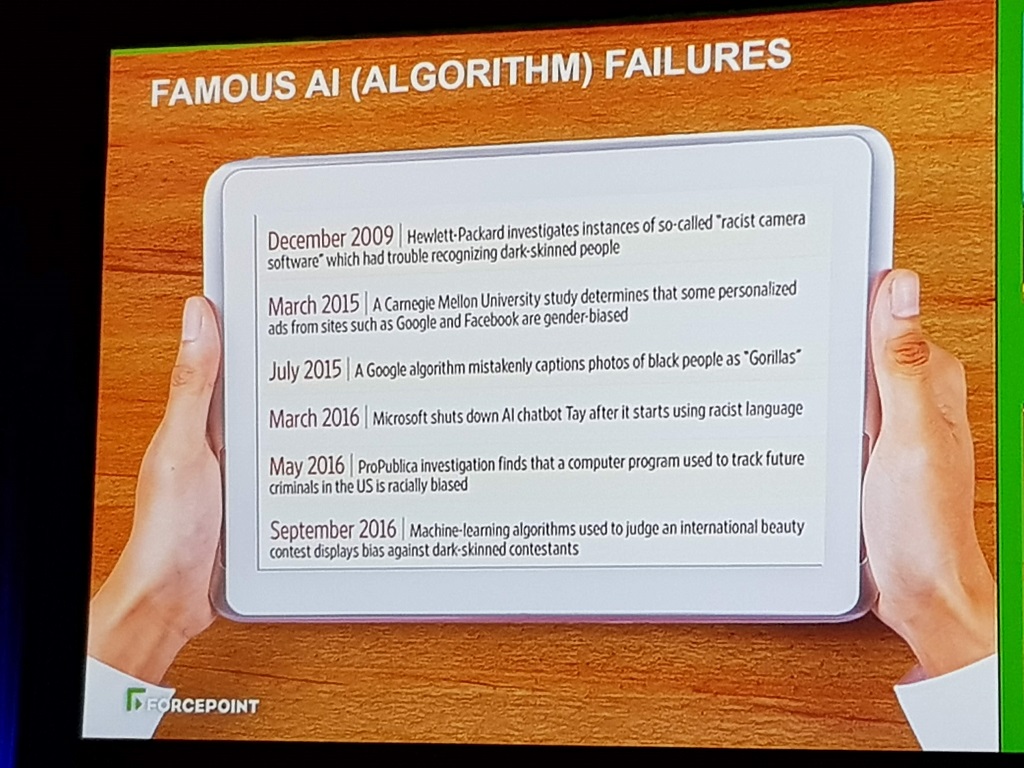

Au fost și câteva exemple celebre de eșecuri ai unor algortimi: unele webcam-uri aveau probleme în a recunoaște persoanele de culoare, algoritmi din Google Images au pus în 2015 eticheta ”gorilă” la fotografiile unor persoane de culoare, iar în 2016 un chatbot al Microsoft a fost eliminat după ce ”învățase” limbaj rasist.

Eșecuri algoritmice (slide din prezentarea lui Marty la Black Hat Las Vegas (foto – HotNews)

Inteligenta artificială reprezintă știința de a face sisteme informatice care pot fi considerate „inteligente”, iar machine learning (învățarea automatizată) reprezintă o disciplină mai restrânsă care presupune crearea de sisteme capabile să învețe din exemplele și din datele pe care le primesc.

De ce pot fi algoritmii periculoși?

De ce pot fi algoritmii periculoși? Fiindcă fac presupuneri pe baza datelor cu care sunt ”hrăniți” și contează mult de la ce date pornim. Pot fi probleme la seturile de date, probleme care fac ca algoritmii să fie, cum se spune în engleză, ”biased”, adică să încline către o anumită parte. Datele pot fi incomplete, pot conține erori, pot fi configurate cu erori, astfel că unele lucruri lipsesc.

Cum guverne din toată lumea se bazează pe tehnologii automatizate pentru a-și menține sistemele în siguranță, încrederea excesivă în algoritmi poate aduce un fals sentiment de securitate digitală. ”Adesea nu sunt înțeleși corect algoritmii. Dacă modifici doar puțin parametri, rezultatul se schimbă”, spune Marty. ”Fiecare algoritm va găsi anomalii în datele tale”.

El spune că acele companii care au bugete mari vor fi, probabil, mai puțin afectate de limitările algoritmilor, fiindcă își permit să adapteze produsele. Însă companiile mai mici folosesc algoritmii fără adaptare suficientă și potrivită. Fără resurse suficiente pot rezulta ”cascade de informații incorecte”.

Ce se poate face? Marty spune că ne putem apăra de folosirea eronată a algoritmilor și inteligenței artificiale dacă este creată o rețea de încredere (belief network) care reprezintă tactica prin care o companie pune unui grup mare de experți întrebări ce au legătură cu indicatorii unui viitor atac cibernetic. El spune că acești indicatori sunt mai folositori decât algoritmii împotriva intruziunilor digitale.

Interesant este că sunt cercetători care spun că folosirea inteligenței artificiale în securitatea informatică poate duce la amplificarea atacurilor cibernetice.

INTERVIURILE HotNews.ro

INTERVIURILE HotNews.ro